Grid UNAM, la experiencia en su implementación

Información del reporte:

Licencia Creative Commons

El contenido de los textos es responsabilidad de los autores y no refleja forzosamente el punto de vista de los dictaminadores, o de los miembros del Comité Editorial, o la postura del editor y la editorial de la publicación.

Para citar este reporte técnico:

Frausto del Río, S.E. et. al (2024). Grid UNAM, la experiencia en su implementación. Cuadernos Técnicos Universitarios de la DGTIC, 2 (4). https://doi.org/10.22201/dgtic.ctud.2024.2.4.71

Silvia Elizabeth Frausto del Río

Dirección General de Cómputo y de

Tecnologías

de Información y Comunicación

Universidad Nacional Autónoma de México

ORCID: 0009-0004-6781-2641

Eduardo Iván Ortega Alarcón

Dirección General de Cómputo y de

Tecnologías

de Información y Comunicación

Universidad Nacional Autónoma de México

ORCID: 0009-0008-8686-5350

María de Lourdes Velázquez Pastrana

Dirección General de Cómputo y de

Tecnologías

de Información y Comunicación

Universidad Nacional Autónoma de México

ORCID: 0009-0000-1445-2145

Resumen:

Grid UNAM surgió como un proyecto coordinado por la Dirección General de Cómputo y de Tecnologías de Información y Comunicación, para optimizar y consolidar el poder computacional distribuido en diversas entidades académicas de la Universidad Nacional Autónoma de México. La metodología propuesta inició con la construcción de un prototipo en un entorno virtual, que transitó por un proceso de pruebas, evaluación y selección de herramientas y tecnologías, antes de lograr el diseño y configuración base que se migró a los clusters de producción. Durante esta fase, el proyecto enfrentó y resolvió desafíos técnicos significativos, como la interoperabilidad entre sistemas heterogéneos, la gestión eficiente de los recursos compartidos y la implementación de medidas de seguridad robustas. Paralelamente, se desarrolló la normatividad necesaria para lograr acuerdos y convenir los lineamientos y las políticas para usar y compartir una infraestructura que involucrara diferentes capacidades y formas de trabajo, tanto humanas como computacionales. El resultado fue la creación de una infraestructura de cómputo distribuida en la Dirección General de Cómputo y de Tecnologías de Información y Comunicación, en los institutos de Astronomía (Ciudad Universitaria, y Ensenada), Ciencias Nucleares y Ciencias de la Atmósfera y Cambio Climático. Esta infraestructura permite compartir el poder de cómputo y de almacenamiento de clusters de alto rendimiento a través de la integración de diversas herramientas, como HTCondor-CE para la orquestación y compartición de recursos computacionales, SLURM para la gestión del sistema de colas, así como un sistema de autenticación basado en OpenID y SciTokens integrado con INDIGO.

Palabras clave:

Grid, HTCondor CE, SLURM, cluster, cómputo de alto rendimiento, normatividad TIC.

1. Introducción

El supercómputo en la UNAM inició en 1991 con la instalación y operación de su primera supercomputadora conocida como Sirio, una máquina CRAY YMP/464 ubicada en la Dirección General de Servicios de Cómputo Académico, hoy Dirección General de Cómputo y de Tecnologías de Información y Comunicación (Acervo histórico del cómputo en la UNAM, 2009). A partir de entonces, se han adquirido máquinas con mejores capacidades de procesamiento y almacenamiento, hasta la actual supercomputadora central Miztli. Sin embargo, algunos institutos y centros de investigación, por iniciativa propia y en respuesta a sus necesidades, optaron por adquirir clusters1 de cómputo de alto rendimiento, con una capacidad de procesamiento menor pero suficiente y dedicada a la atención local e inmediata de los proyectos científicos de sus comunidades. (Grid UNAM, s.f.)

Desde una visión institucional, la UNAM realizó una inversión de infraestructura de cómputo de alto rendimiento, distribuida inclusive entre campi, con posibles periodos de subutilización de estos recursos.

Según la Comisión Técnica de Grid UNAM (2023), las grid* de cómputo de alto rendimiento han demostrado ser herramientas indispensables para el desarrollo científico en el mundo. En la Memoria UNAM 2010 (Ania, 2010), se menciona la participación de la universidad en proyectos relacionados con infraestructura de cómputo en grid para uso científico. Entre ellos, se identifican EELA (E-science grid facility for Europe and Latin America) y GISELA (Grid Initiatives for e-Science virtual communities in Europe and Latin America), dos de los proyectos en los que la Dirección General de Cómputo y de Tecnologías de Información y Comunicación (DGTIC) junto con el Instituto de Ciencias Nucleares (ICN) y la FES Cuautitlán sumaron esfuerzos para aprovechar recursos que la Unión Europea había brindado para el desarrollo de proyectos multi-institucionales.

Para impulsar la compartición de recursos computacionales que se encontraban disgregados en la universidad y buscar su optimización, la UNAM dispuso en su Plan de Desarrollo Institucional PDI 2019-2023, en el Programa 3.2 Investigación e Innovación, el proyecto 7 “Actualizar y consolidar la infraestructura de cómputo orientada a la investigación y capacitar al personal académico de todos los campi en materia de acceso y operación de los recursos existentes” (Graue, 2020).

Para la atención a este proyecto, la DGTIC, los institutos de Astronomía (Ciudad Universitaria, IA y Ensenada, IAE), Ciencias Nucleares (ICN) y Ciencias de la Atmósfera y Cambio Climático (ICAyCC) trabajaron en la construcción de una red basada en la compartición de infraestructura de equipo de cómputo de alto rendimiento, aprovechando los recursos de Miztli y los de algunos de los clusters adquiridos en las entidades académicas, resultando con esta iniciativa la creación de Grid UNAM.

El objetivo general de Grid UNAM se definió como “Poner a disposición de la comunidad científica de la UNAM, el acceso al uso de recursos compartidos de cómputo de alto rendimiento para apoyar el desarrollo de sus proyectos de investigación, mediante una red que permita distribuir los trabajos entre los distintos recursos de cómputo y de almacenamiento que aporta cada entidad y dependencia participante” (Comisión Técnica de Grid UNAM, 2023).

Uno de los hitos fundamentales de este proyecto fue integrar el grupo técnico para el desarrollo de un prototipo, cuyo principal reto fue aprender sobre el funcionamiento de una grid computacional y afianzar ese conocimiento durante el diseño, configuración, instalación y pruebas de operación en los clusters que administraban, de forma que se pudiera tener acceso a los recursos que se comparten a través de la grid desde cualquiera de los nodos de acceso configurados en cada una de las entidades.

Los técnicos académicos e investigadores encargados de la construcción de esta grid surgieron de la Iniciativa de Cómputo de Alto Rendimiento y Uso de Supercómputo (ICARUS, s.f.), que integra a responsables de operar y administrar clusters HPC* en la UNAM.

La construcción de la Grid UNAM representó un desafío tecnológico y, sobre todo, logístico, que buscó consolidar el poder de cómputo distribuido entre las entidades participantes de la UNAM, interconectadas mediante una red de alta velocidad de 10 Gbps. El proceso de implementación involucró una investigación exhaustiva y una evaluación cuidadosa de las tecnologías más adecuadas para satisfacer las demandas de interoperabilidad y eficiencia en un entorno con clusters heterogéneos. Se optó por utilizar HTCondor-CE* como middleware*, debido a su flexibilidad y capacidad para integrar diferentes sistemas de gestión de recursos, facilitando la unión de los clusters participantes en una única entidad lógica. SLURM* (SchedMd, s.f.) fue elegido como el sistema de colas dado su rendimiento y capacidad de adaptación a las necesidades específicas de cada cluster, permitiendo una gestión óptima de los recursos computacionales. Para el sistema de autenticación, se seleccionó INDIGO*, que utiliza un esquema de autenticación basado en OpenID* para el uso de tokens* que es el medio principal de autenticación del middleware, lo cual proporciona un nivel adicional de seguridad y control de acceso, fundamental en un entorno colaborativo y distribuido. MinIO* se integró como el sistema de almacenamiento, seleccionado por su capacidad de escalabilidad y su compatibilidad con las necesidades de almacenamiento requeridas para Grid UNAM (Lackschewitz et al., 2022).

Durante la fase de implementación, se analizaron y resolvieron asuntos de distinta complejidad, entre ellos, la integración de los diferentes sistemas de software y hardware, la gestión eficiente de los recursos compartidos entre las entidades participantes y la necesidad de asegurar tanto la estabilidad como la seguridad de la infraestructura. Sin embargo, una de las cuestiones más discutidas para lograr una logística consistente en la grid fue la unificación de políticas y métodos de administración de las entidades participantes, la cual fue resuelta gracias a la colaboración entre dependencias.

Este documento pretende compartir la experiencia de la implementación de esta infraestructura indicando las herramientas seleccionadas, algunas de sus características y formas de operación, así como las configuraciones, resultados de pruebas y puesta en operación de la grid, enfatizando siempre que la construcción de Grid UNAM fue obra del multicitado grupo de expertos.

2. Metodología

Para la construcción de la grid en la UNAM, el Comité Académico de Supercómputo (CAS) aprobó el establecimiento de la Comisión Técnica de Grid UNAM, misma que coordinó tres grupos de trabajo: el de desarrollo del prototipo, el de construcción de la red de comunicación y el de desarrollo de la normatividad y lineamientos operativos para definir el uso de sus recursos en hardware, software y telecomunicaciones. Cada uno de estos grupos estableció hitos para el cumplimiento de sus objetivos específicos, siendo los de la construcción del prototipo y el desarrollo de la normatividad los que se revisarán a lo largo de este reporte.

3. Desarrollo técnico

El grupo encargado de la construcción del prototipo fue integrado por personal de cada una de las entidades participantes de Grid UNAM. Esto permitió tener una visión completa de las necesidades de cada cluster, así como las políticas y metodologías de trabajo empleadas en cada cluster de cómputo de alto rendimiento.

Este grupo técnico de expertos estableció los siguientes hitos para el desarrollo del prototipo:

- La definición de la solución para la compartición de recursos computacionales.

- La definición del sistema de colas.

- La autenticación y autorización de solicitudes.

- La definición del sistema de almacenamiento a utilizar en la grid.

- Posibles esquemas para la ejecución de trabajos.

- Construcción del prototipo de grid

Para lograr los hitos propuestos, era necesario realizar pruebas en una infraestructura que fuera accesible por los clusters de todas las entidades participantes en la grid, con direcciones IP públicas y con un nombre de dominio. Para no interrumpir el servicio que brindaban los clusters de producción de cada entidad, se decidió implementar el prototipo en una infraestructura virtual, donde se utilizarían máquinas virtuales que pudieran simular el funcionamiento normal de un cluster: un nodo para someter trabajos a la grid (nodo submit), un nodo de administración de recursos (nodo maestro) y dos nodos de cálculo para la ejecución de trabajos.

La infraestructura se creó con máquinas virtuales que disponían de 2 cores CPU, 2 GB de RAM y 50 GB de almacenamiento en disco local.

El objetivo principal del prototipo fue someter un trabajo sencillo en cualquiera de las entidades participantes, haciendo uso de cualquiera de los nodos submit configurados en la grid. La primera prueba consistió en ejecutar el programa hostname de GNU/Linux en cualquiera de los clusters virtuales de la grid. A esta prueba se le llamó el ejercicio del “Hola mundo”, haciendo referencia al ejercicio conocido entre programadores cuando se está aprendiendo un nuevo lenguaje de programación. Para ello, se configuraron las distintas capas de software, descritas más adelante, que hicieron posible que, desde cualquiera de los cuatro nodos submit de las entidades participantes, se sometiera un trabajo y se ejecutara en cualquiera de los clusters virtuales de la grid.

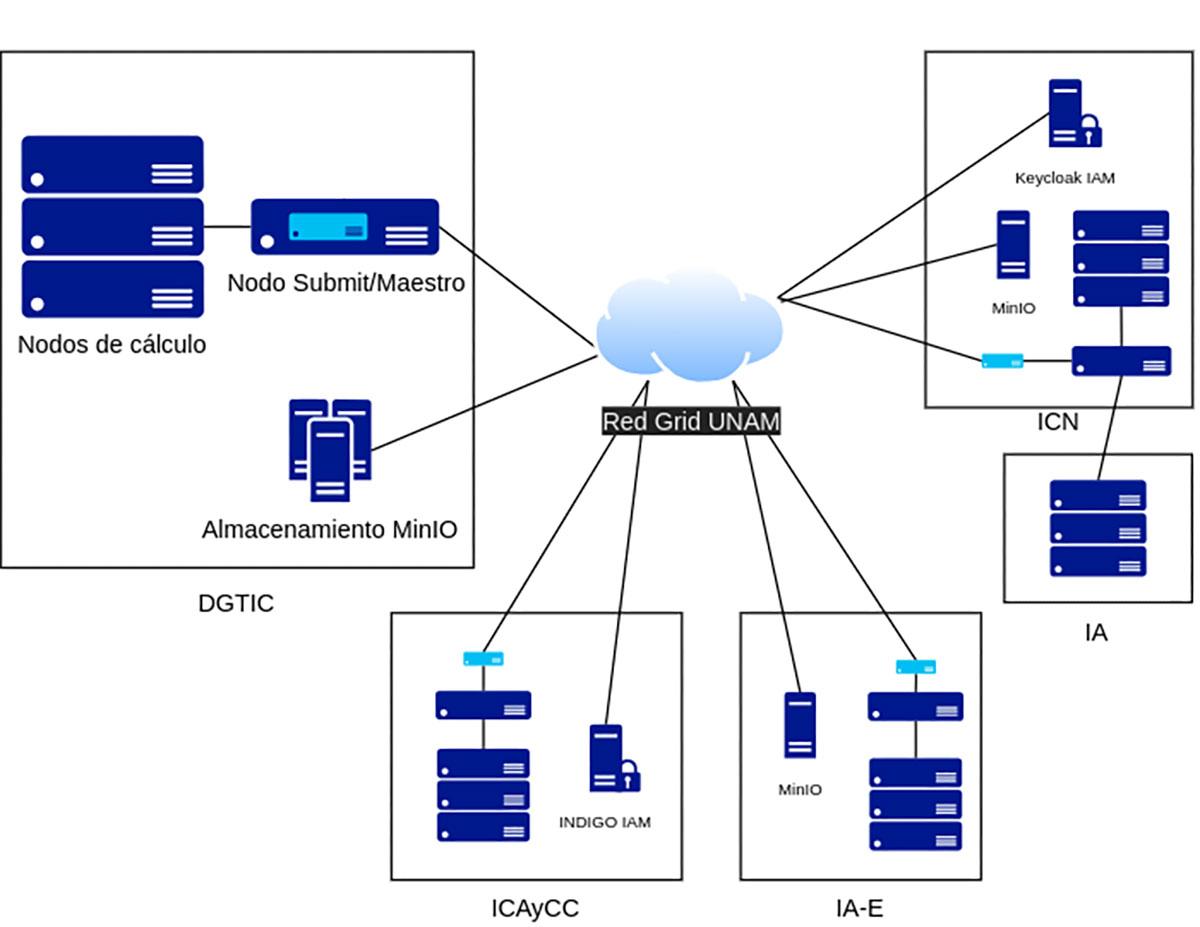

En la figura 1, se ilustra la arquitectura actual de la Grid UNAM. En cada uno de los clusters en producción, se dispone de los nodos de cómputo que se comparten en la grid y de nodos adicionales que brindan los servicios necesarios para la operación de la infraestructura, como el nodo submit, y el nodo maestro (en el caso de DGTIC, ambos servicios se encuentran en un mismo nodo).

Figura 1

Arquitectura general de Grid UNAM

También puede observarse que los clusters de IA-E, ICN y DGTIC cuentan con capacidad de almacenamiento (MinIO) accesible por toda la grid y que los servicios de autenticación los brindan los clusters de ICAyCC e ICN.

- Sistema para la compartición de recursos computacionales

A partir de una investigación sobre el funcionamiento de otras grids como la OSG (Open Science Grid Site Documentation, s.f.), el grupo de expertos se dedicó a estudiar el software HTCondor*, antes conocido únicamente como Condor (Tannenbaum, 2012) y que, según Thain et al. (2004), desde su origen, HTCondor permite la administración de tareas, la creación de políticas para la distribución de recursos (scheduler) y la integración de sistemas heterogéneos. Debido a todas estas funcionalidades, el grupo técnico eligió HTCondor y su complemento HTCondor-CE (compute entrypoint), como el middleware para orquestar y distribuir el trabajo en la grid.

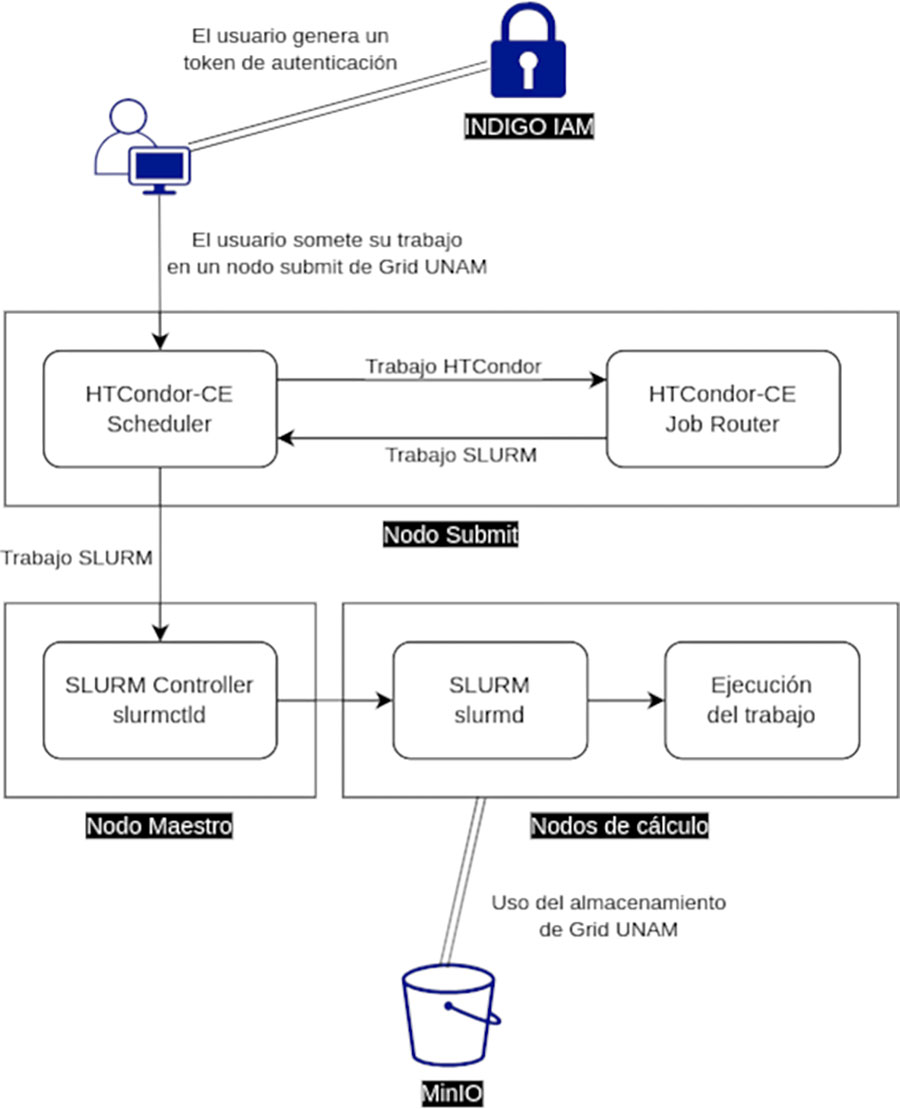

Como se mencionó anteriormente, existe un complemento de HTCondor llamado HTCondor-CE, el cual fue el software elegido para ser utilizado por la infraestructura de Grid UNAM. De acuerdo con (Bockelman et al, 2021), HTCondor-CE opera como una puerta de entrada de solicitudes de asignación de recursos (RARs por sus siglas en inglés), transfiriendo estas solicitudes al sistema de colas (batch) local. En una visión simplista, el CE es la puerta de entrada de las solicitudes provenientes de usuarios distantes que requieren la asignación de recursos computacionales. Para delegar las solicitudes de asignación de recursos, HTCondor-CE utiliza el demonio Job Router para transformar las tareas (jobs) de acuerdo con una política configurable. Otras características que distinguen a HTCondor-CE son su escalabilidad, contar con herramientas para depuración de tareas y soportar diversos tipos de sistemas batch (Open Science Grid Site Documentation, s.f.). La figura 2 ilustra el funcionamiento de HTCondor-CE en Grid UNAM.

Figura 2

Funcionamiento esquemático del envío de un trabajo con HTCondor-CE en Grid UNAM

En el caso de Grid UNAM, HTCondor-CE está conectado al sistema SLURM, el cual se encarga de gestionar la distribución y ejecución de los trabajos en los nodos de cálculo, asegurando un uso eficiente de los recursos disponibles. Adicionalmente, los nodos de cálculo pueden acceder al sistema de almacenamiento MinIO durante la ejecución de los trabajos, garantizando así un entorno de alto rendimiento y disponibilidad para la comunidad científica.

- Definición del sistema de colas

Debido a la facilidad de utilizar el sistema de colas HTCondor y su complemento HTCondor-CE, el grupo técnico optó por utilizar esta combinación para comprender el funcionamiento del reenvío de trabajos entre el middleware y el sistema de colas. Gracias a la afinidad y transparencia que existe entre esta dupla, el trabajo técnico pudo enfocarse en la configuración del middleware y en su integración con el sistema de autenticación para abrir el paso a las pruebas de integración con otros sistemas de administración de recursos (LRMS por sus siglas en inglés).

Para verificar la operación entre HTCondor-CE y los sistemas de administración de recursos SLURM, PBS y LSF, también llamados sistemas de colas, el grupo técnico basó sus pruebas en la consulta de los jobs o los trabajos que estaban en ejecución en cada uno de los sistemas antes mencionados. Aunque con esto se había probado que el middleware HTCondor-CE soportaba la integración con distintos sistemas de colas, lo cierto es que dos de los clusters ya usaban SLURM y los otros dos no tenían inconveniente en usarlo, por lo que se analizó la posible migración de los clusters que integran la grid al sistema SLURM. Finalmente, el grupo técnico tomó la decisión de homogeneizar la infraestructura e instalar este gestor de recursos en todos los clusters de la grid, tomando en cuenta dos consideraciones importantes: 1) si en todas las entidades se tenía el mismo software para administrar los recursos, sería más fácil atender y resolver alguna anomalía; 2) todas las áreas universitarias participantes en la grid, planeaban migrar al sistema de colas SLURM en algún momento.

Las características más destacadas de SLURM son que es un software de código abierto, es tolerante a fallas, distribuye trabajos en clusters grandes o pequeños y es altamente escalable (Yoo et al., 2003). Para la distribución de las cargas de trabajo, SLURM designa recursos computacionales exclusivos y no exclusivos por periodos de tiempo que permitan la ejecución de los trabajos y media la asignación de recursos administrando una cola de trabajos pendientes. Funcionalidades específicas, como la contabilidad de uso de recursos, pueden activarse mediante tres plugins opcionales, que permiten el registro de los datos en texto plano o en una base de datos. Para la Grid UNAM, se consideró conveniente implementar el registro de la contabilidad de los trabajos en archivos en texto plano (Flores, 2024).

- Autenticación y autorización federada.

HTCondor-CE requiere de conexiones seguras para la autorización de envío de tareas, la autenticación de usuarios y despacho de trabajos. Debido a esto, su configuración soporta la utilización de certificados X.509 (SSL.com., s.f.) para autenticar conexiones SSL (Secure Sockets Layer), así como otros medios de autenticación como SciToken. En una primera fase, para el desarrollo de las pruebas, se utilizaron certificados X.509 emitidos por la Autoridad Certificadora de la DGTIC con éxito. Sin embargo, durante esta etapa se conoció que la nueva versión del software HTCondor CE sustituye la autenticación PKI por el uso de tokens.

Debido a esto, el grupo de expertos implementó la autenticación en Grid UNAM, con el sistema SciToken, como se expone en (Scitokens Organization, s.f.), ya que éste habilita ambientes federados para autorización y acceso en infraestructuras distribuidas de cómputo científico. (Soporte y atención a usuarios, s.f. y Withers, 2018).

Para operar como sistema federado, el grupo de desarrollo utilizó el proveedor de identidades creado para la Red Inalámbrica Universitaria (RIU) de nuestra universidad y, para la creación de tokens, lo asoció con el sistema INDIGO de administración de identidad y acceso (IAM por sus siglas en inglés).

- La definición del sistema de almacenamiento a utilizar en la grid.

La configuración inicial para el almacenamiento de los resultados que generaban los trabajos sometidos a la grid, consistió en un directorio compartido por medio del Sistema de Archivos de Red (NFS por sus siglas en inglés), que pertenecía al nodo submit de cada uno de los clusters, así como un directorio llamado /scratch, en el que los trabajos que se ejecutan en un nodo disponen de una mayor velocidad de almacenamiento porque es un disco local de estado sólido de alto rendimiento. Sin embargo, la capacidad de almacenamiento de estos espacios resultaba insuficiente para cubrir las necesidades de los trabajos, por lo que se buscaron alternativas para atender los requerimientos de todas las entidades participantes.

El grupo técnico decidió probar el sistema de almacenamiento llamado MinIO por su capacidad de integración con el sistema de autenticación de Grid UNAM y por sus características de gestión de archivos a través de línea de comandos, lo cual facilita que los trabajos puedan acceder al sistema de almacenamiento mediante sencillas instrucciones.

Adicionalmente, como MinIO es un sistema compatible con la API de S3*, permite acceder al sistema de archivos desde cualquiera de las entidades participantes en la grid, almacenar los resultados de los trabajos a medida que se van generando, así como ofrecer la posibilidad de que pueda utilizarse como un sistema de almacenamiento externo, mediante el uso de su herramienta mcli, para poder leer archivos de entrada o copiar resultados finales.

- Esquemas para la ejecución de trabajos

Para facilitar la ejecución de trabajos dentro de Grid UNAM, se adoptaron esquemas tradicionales que priorizan tanto la eficiencia como la flexibilidad en el manejo de los datos generados. Dichos esquemas permiten a los usuarios la posibilidad de compilar su código directamente en el trabajo sometido o utilizar alguna de las aplicaciones previamente instaladas para someter su trabajo.

Durante el proceso de envío, pueden especificar el uso del almacenamiento MinIO, lo que permite que los resultados se almacenen de manera persistente y sean accesibles desde cualquiera de los clusters que forman parte de la grid o, incluso, a través del sitio web. El almacenamiento local en el directorio /scratch es utilizado de forma predeterminada por todos los trabajos sometidos a la grid, ya que permite una escritura de alta velocidad en comparación con el uso del sistema de almacenamiento masivo proporcionado por MinIO y, en el caso de DGTIC, la velocidad es aún superior gracias al uso de discos SSD de alto rendimiento; sin embargo, el espacio disponible en este directorio es limitado, por lo que los datos que se almacenan durante la ejecución son eliminados automáticamente una vez concluido el trabajo, optimizando así el uso del espacio. Los usuarios pueden realizar una copia de los resultados relevantes hacia el almacenamiento MinIO antes de que se eliminen, incluyendo una instrucción que transfiera automáticamente los resultados a MinIO.

Adicionalmente al esquema tradicional de envío de trabajos, la implementación del software Apptainer (Apptainer, s.f.) en todos los clusters de la grid posibilita la ejecución de aplicaciones dentro de contenedores, garantizando así la uniformidad y la estabilidad de los entornos de trabajo. Esta solución no sólo facilita la portabilidad de las aplicaciones, sino que también permite a los usuarios ejecutar un software que requiere configuraciones específicas o versiones particulares, ampliando considerablemente la flexibilidad y las capacidades operativas de Grid UNAM. Es importante mencionar que el grupo de expertos se inclinó hacia Apptainer debido a su compatibilidad con los diferentes sistemas operativos GNU/Linux de los clusters de la grid y por su capacidad para ejecutar aplicaciones en contenedores sin necesidad de contar con privilegios de superusuario, lo que lo convierte en la opción ideal para el entorno de Grid UNAM. Además, el grupo de expertos encargado del desarrollo de la grid ya contaba con amplia experiencia en el uso de este software, lo que facilitó su implementación y aseguró un entorno de ejecución consistente para las aplicaciones, independientemente del cluster en el que se ejecuten.

- Normatividad

Simultáneamente al desarrollo de las etapas que describen la creación del prototipo y su evolución hasta llegar a la infraestructura actual de la Grid UNAM, se formaron grupos de trabajo para elaborar la documentación requerida y determinar las normas de operación de los distintos grupos involucrados en este proyecto. En primer lugar, el Reglamento Interno de la Comisión Técnica de la Grid UNAM (CTG), en el que se delimitaron las funciones de la comisión, se precisó su integración y cuáles serían las responsabilidades de cada uno de sus miembros, se reguló la organización y el seguimiento de las sesiones, así como la toma de acuerdos de este grupo de trabajo, que ha estado dedicado principalmente a coordinar, constituir y reglamentar un nuevo modelo de servicio para la comunidad de investigadores de la UNAM.

Posteriormente, la CTG se encargó de la redacción de los “Lineamientos de conformación y uso de la Grid UNAM” (Comisión Técnica de Grid UNAM, 2023), cuyo propósito fue establecer las directrices para la colaboración y el uso de los recursos de la Grid UNAM. En este documento, se definieron y describieron los fundamentos para la conformación de la Grid UNAM, así como las responsabilidades correspondientes a cada grupo de acuerdo con el rol que le corresponde dentro de la grid, como: usuarios de entidades miembro, usuarios de entidades participantes, el gobierno y la operación de la grid.

Al mismo tiempo, se inició la discusión sobre las Políticas de uso del servicio Grid UNAM, la cual tomó casi un año y se trabajó con la finalidad de asegurar el uso y el manejo correcto de los recursos por parte de los usuarios y de los operadores del mismo, considerando la aplicación de los principios de la seguridad informática: confidencialidad, integridad y disponibilidad (Humayun et al., 2020). La discusión en torno a las políticas contempló dos grandes rubros: los compromisos y las responsabilidades del servicio, que conciernen tanto a los usuarios como a los operadores del servicio. En ese sentido, se trataron aspectos relacionados con la asignación de recursos, las condiciones de uso de las cuentas y de los recursos asignados, el soporte técnico y el software de usuario. Se propuso que las responsabilidades se agruparan por tipo de participante, de tal forma que se dispuso un apartado para la mesa de soporte, otro para los usuarios y otro para los titulares de proyectos. La suspensión y cancelación de cuentas tuvo también su propio apartado al considerarlo un tema relevante tanto para usuarios como para operadores del servicio (Comisión Técnica de Grid UNAM, 2023).

- Portal Informativo de la Grid UNAM

Uno de los hitos más relevantes para dar difusión a este proyecto fue la creación de un portal informativo en el que los usuarios o interesados en este servicio puedan encontrar información sobre la normatividad, los proyectos que reciben o han recibido apoyo del servicio y la documentación sobre el servicio, tanto para usuarios y operadores como para quienes puedan estar interesados en colaborar o en acceder a los recursos disponibles en la Grid UNAM.

El Portal Informativo de la Grid UNAM es el resultado de reuniones semanales en las que se realizó un trabajo académico y colaborativo, impulsado y coordinado por la CTG. De cada reunión se obtenía un documento con los textos y propuestas de diseño, que se pasaba a la persona responsable de construir el sitio web y de aplicar los cambios indicados, los cuales eran revisados en la siguiente reunión del grupo responsable del contenido. Este proceso iterativo duró poco más de seis meses y dio como resultado un trabajo que reitera el espíritu de cooperación y reciprocidad inherente a la grid, al integrar en este proyecto tanto a los representantes del CAS como a los de las entidades participantes, a los desarrolladores de la grid computacional y al personal de diversas áreas de DGTIC que participaron en el diseño del logo y de la página, en la revisión de estilo y en la construcción del sitio web. Alcanzar este hito dio paso a la publicación de la nota en Gaceta UNAM sobre la implementación de esta infraestructura (DGTIC, 2023).

4. Resultados

A partir de las configuraciones operando en los clusters de alto rendimiento en producción de las entidades participantes, se planteó una invitación a investigadores de la comunidad científica para la ejecución de trabajos con el uso de esta infraestructura.

La invitación a un número cerrado de científicos resultó en la ejecución de proyectos de distintas áreas de conocimiento como química, sistemas planetarios e inteligencia artificial, cosmología, astrofísica, ciencia de datos, física de altas energías, ciencias de la salud y filogenética.

Los recursos para procesamiento y almacenamiento disponibles en la grid para el desarrollo de estas pruebas se muestran en las Tablas 1 y 2.

Tabla 1

Recursos de procesamiento disponibles para la prueba en clusters en producción

| ÁREA UNIVERSITARIA UNAM | CAPACIDAD EN CORES | SERVIDORES | MEMORIA/SERVIDOR [GB] |

| LAMOD ICN | 192 | 4 | 128 |

| LAMOD IA | 96 | 4 | 32 |

| DGTIC-MIZTLI | 256 | 8 | 256 |

| ICN-DGTIC-ALICE | 128 | 4 | 128 |

| ICAyCC | 96 | 4 | 64 |

| IA-ENSENADA | 64 | 2 | 512 |

Tabla 2

Recursos de almacenamiento disponibles para la prueba en clusters en producción

| ÁREA UNIVERSITARIA UNAM | TIPO DE RECURSO | CAPACIDAD [TB] | SERVIDORES | MEMORIA/SERVIDOR [GB] |

| ICN-DGTIC- ALICE | S3 | 120 | 1 | 128 |

| LAMOD. ICN | S3 | 2 | 1 | 16 |

| IA-Ensenada | S3 | 50 | 1 | 16 |

En octubre de 2023, el CAS aprobó el uso de la infraestructura a siete de los proyectos que participaron en las pruebas iniciales. Se espera que en los próximos meses, tras la ejecución de cientos de trabajos y del análisis de resultados correspondiente, dichos proyectos empiecen a reportar la producción científica que lograron obtener con el uso de los recursos compartidos en la grid.

En cuanto a la operación, las pruebas de uso de la infraestructura han permitido detectar áreas de oportunidad para mejorar el funcionamiento de la estructura organizacional implementada en Grid UNAM, entre las que se pueden mencionar: la aprobación de solicitudes de cuentas nuevas en el sistema INDIGO, ya que, por el momento, depende de la aprobación manual a cargo de una sola persona, o la correlación entre cuentas de usuario de la grid y los propietarios reales de dichas cuentas, que se requiere para facilitar el reporte de la contabilidad de uso de recursos.

En lo que respecta a la estructura organizacional de la Comisión Técnica, a cargo de la Dirección de Sistemas y Servicios Institucionales de la DGTIC, ha sido de gran utilidad contar con la colaboración de otras áreas de la misma dependencia: la Dirección de Telecomunicaciones, responsable del diseño y de la supervisión de la construcción de la red a 10 Gbps que conecta a las cuatro entidades participantes; y la Dirección de Colaboración y Vinculación que contribuyó en la elaboración de la normatividad para la gobernanza de Grid UNAM.

5.Conclusiones

Con la interconexión de estos clusters, a través de una grid, y con la participación de los investigadores invitados, se logró verificar la funcionalidad de esta infraestructura y abrir oportunidades a más comunidades científicas para el acceso a estas herramientas, sin limitarse a la disponibilidad de los recursos centrales de Miztli.

A partir de los resultados exitosos de este proyecto, la UNAM cuenta con una herramienta propia similar a las que, a nivel mundial, han demostrado su utilidad en el desarrollo científico y, gracias a ello, se está creando una comunidad universitaria especializada en grids, con el potencial de incidir en la formación de recursos humanos a través del Plan de Becarios de Supercómputo de la DGTIC y de la especialización en Cómputo de Alto Rendimiento del Programa de Posgrado en Ciencia e Ingeniería de la Computación.

A partir de la ejecución de pruebas y de la interacción con los investigadores, queda claro que la infraestructura de Grid UNAM requiere de mantenimiento y monitoreo constante para asegurar su estabilidad y un uso óptimo de los recursos, con el fin de garantizar un soporte adecuado y sostenido. Asimismo, la renovación tecnológica es indispensable para mantener la grid a la vanguardia y que pueda convertirse en una herramienta competitiva y escalable, capaz de contribuir al desarrollo de los proyectos de investigación afines a este modelo de cómputo distribuido y de fomentar el uso de este tipo de recursos computacionales entre la comunidad universitaria.

Como trabajo a futuro, se espera recibir retroalimentación de los usuarios para mejorar y concluir la documentación necesaria para facilitar el uso de la Grid UNAM. Mientras tanto, se logró establecer una infraestructura robusta y escalable que no sólo ofrece una plataforma complementaria para apoyar a la investigación científica en su necesidad de acceder a recursos de cómputo de alto rendimiento y de almacenamiento distribuido en la universidad, sino que también se ha convertido en una herramienta para fomentar el crecimiento académico del personal involucrado en su diseño y desarrollo.

Agradecimientos

Agradecemos al grupo de técnicos académicos que diseñaron e implementaron la infraestructura de Grid UNAM: Álvarez I., Badillo V., Clemente J., Cruz P., Díaz L., Escobar L., Fernández J., Flores L., Hernández A., Hernández B., Itehua L., Murrieta E., Ortega E., Pantoja R., Sánchez E.; a los compañeros de DGTIC por todo el apoyo brindado durante el diseño y desarrollo del proyecto: Alavez C., Cano R., Castañeda L., Erazo K., González A., Santillán A., Vázquez A.; así como a los miembros de la CTG por la coordinación y el seguimiento para la implementación y puesta en operación de la infraestructura de Grid UNAM: Díaz L., Frausto S., García J., Nellen L., Ramirez A., Rodríguez R., Valenzuela O., Vega L., Velázquez M. Un agradecimiento especial a los titulares de los institutos de Astronomía, Ciencias de la Atmósfera y Cambio Climático, Ciencias Nucleares y de la DGTIC por las facilidades brindadas para la realización de este proyecto.

Referencias

Acervo histórico del cómputo en la UNAM (2009). 50 años del cómputo en México Cap. 9 En la frontera de todos los laberintos Supercómputo. Recuperado el 07 de agosto de 2024 de https://www.historiadelcomputo.unam.mx/wp-content/uploads/2023/11/TEMA-9-SUPER.pdf

Ania, I. (2010), Coordinación General de Planeación y Simplificación de la Gestión Institucional, Memoria UNAM 2010: Dirección General de Cómputo y de Tecnologías de Información y Comunicación (6). Recuperado 07 de agosto de 2024 de https://www.planeacion.unam.mx/Memoria/2010/PDF/12.4-DGTIC.pdf

Apptainer (s.f.) Apptainer User Guide. Introduction to Apptainer. Recuperado 23 de agosto de 2023 dehttps://apptainer.org/docs/user/latest/introduction.html#why-use-apptainer

Bockelman, B., Livny, M., Lin, B., & Prelz, F. (2021). Principles, technologies, and time: The translational journey of the HTCondor-CE. Journal of Computational Science, 52(101213), 101213. https://doi.org/10.1016/j.jocs.2020.101213

Comisión Técnica de Grid UNAM (2023). Glosario. Recuperado 7 de octubre de 2024 https://grid.unam.mx/index.php/glosario

Comisión Técnica de Grid UNAM (2023). Portal Informativo de la Grid UNAM (2023). Recuperado 23 de agosto de 2023 de https://grid.unam.mx

Comisión Técnica de Grid UNAM (2023). Lineamientos de conformación y uso de la Grid UNAM (2023). Recuperado 23 de agosto de 2023 de https://grid.unam.mx/wp-content/uploads/2023/07/lineamientos2023.pdf

Comisión Técnica de Grid UNAM (2023). Políticas de uso de servicio de la Grid UNAM. Recuperado el 23 de agosto de 2023 de https://grid.unam.mx/wp-content/uploads/2023/08/Politicas_grid.pdf

DGTIC (2023). Grid UNAM, red de cómputo de alto rendimiento. Gaceta UNAM Ciudad Universitaria 9 de noviembre de 2023. (5429), pp. 9. https://www.gaceta.unam.mx/wp-content/uploads/2023/11/231109.pdf

Durner, D., Leis, V., Neumann, T. (2023). Exploiting Cloud Object Storage for High-Performance Analytics. Very Large Data Bases Conference VLDB. Recuperado de https://www.vldb.org› vol16› p2769-durner.pdf

Flores, L. (2024). Contabilidad de recursos en sistemas de cómputo de alto rendimiento en la Grid UNAM. Cuadernos Técnicos Universitarios De La DGTIC, 2(1). https://doi.org/10.22201/dgtic.ctud.2024.2.1.31 (Original work published 13 de febrero de 2024)

Graue, E. (2020). Plan de desarrollo institucional 2019-2023. Universidad Nacional Autónoma de México. Recuperado 08 de agosto de 2024 desdehttps://www.planeacion.unam.mx/Planeacion/Apoyo/PDI_2019-2023.pdf

Grid UNAM. (s.f.). Universidad Nacional Autónoma de México. Maqueta de prueba de una grid de cálculo masivo GridUNAM. Recuperado agosto 23, 2023 desde https://docs.google.com/document/d/1-5H3pfYk2IGlfzmGObTd51TmweD4rAZW/edit#

Humayun, M., Niazi, M., Jhanjhi, N. Z., Alshayeb, M., & Mahmood, S. (2020). Cyber security threats and vulnerabilities: A systematic mapping study. Arabian Journal for Science and Engineering, 45(4), 3171–3189. https://doi.org/10.1007/s13369-019-04319-2

ICARUS (s.f.). Universidad Nacional Autónoma de México. Iniciativa de Cómputo de Alto Rendimiento y uso de Supercómputo. Recuperado 23 de agosto de 2023 de https://www.icarus.unam.mx

INDIGO IAM. (s.f.). INDIGO IAM Documentation. Recuperado 23 de agosto de 2023 de https://indigo-iam.github.io/v/v1.8.3/docs/overview/

Lackschewitz, N. M., Krey, S., Nolte, H., Christgau, S., Oeste, S., & Kunkel, J. (2022). Performance Evaluation of Object Storages (NHR2022). Gwdg.de. Recuperado el 23 de agosto de 2024, de https://gwdg.de/pdf/Performance_Evaluation_of_Object_Storages_NHR2022_.pdf

OpenID foundation. (2023). Discover OpenID and OpenID connect . Recuperado el 8 de octubre desde https://openid.net/developers/discover-openid-and-openid-connect/

Open Science Grid Site Documentation (s.f.). HTCondor-CE Overview. Recuperado el 23 de agosto de 2023 desde https://osg-htc.org/docs/compute-element/htcondor-ce-overview/

Scitokens Organization (s.f.). Federated Authorization for Distributed Scientific Computing. Recuperado 23 de agosto de 2023 de https://scitokens.org/

SchedMd (s.f.). SLURM Workload Manager Documentation. Recuperado 23 de agosto de 2023 de https://slurm.schedmd.com/

Soporte y atención a usuarios (s.f.). Universidad Nacional Autónoma de México. Para operadores. Manejo de tokens. Recuperado agosto 23, 2023 desde https://docs.grid.unam.mx/operadores/manejo-tokens/

SSL.com. (s.f.). ¿Qué es un certificado X.509?. Consultado agosto 23, 2023 desde https://www.ssl.com/es/preguntas-frecuentes/%C2%BFQu%C3%A9-es-un-certificado-x-509%3F

Thain, D., Tannenbaum, T., and Livny, M.. (2004). Distributed Computing in Practice: The Condor Experience. Computer Sciences Department, University of Wisconsin-Madison. Recuperado 23 de agosto 2023 desde https://htcondor.org/doc/condor-practice.pdf

Tannenbaum, T. (2012). [Condor-users] "Condor" name changing to "HTCondor". Mailing List Archives. University of Wisconsin-Madison. Recuperado agosto 23, 2023 de https://lists.cs.wisc.edu/archive/htcondor-users/2012-October/msg00110.shtml

Withers, A., Bockelman, B., Weitzel, D., Brown, D., Gaynor, J., Basney, J., Tannenbaum, T., & Miller, Z. (2018). SciTokens: Capability-based secure access to remote scientific data. Proceedings of the Practice and Experience on Advanced Research Computing. https://doi.org/10.1145/3219104.3219135

Yoo, A. B., Jette, M. A., & Grondona, M. (2003). SLURM: Simple Linux Utility for Resource Management. En Lecture Notes in Computer Science (pp. 44–60). Springer Berlin Heidelberg. https://doi.org/10.1007/10968987_3

1 Con el propósito de facilitar la lectura y comprensión de este trabajo, se anexará al final del reporte un glosario con los conceptos de algunos términos técnicos utilizados, los cuales se identificarán con un *.

Glosario

Cluster. Conjunto de computadoras que mediante conexiones y configuraciones especiales se logran unificar de manera que actúen como si fuese una sola computadora (Comisión Técnica de Grid UNAM, 2023).

Grid. Modelo de computación distribuida que surge para compartir un conjunto de recursos (hardware y software) entre un grupo de entidades geográficamente distribuidas, coordinadas, organizadas e interconectadas por redes de alta velocidad. A través de una capa de software (middleware), los recursos se pueden gestionar como una sola infraestructura (Comisión Técnica de Grid UNAM, 2023).

HPC (High Performance Computing). Modelo que se caracteriza por la ejecución de trabajos paralelos muy acoplados, que requieren un gran poder de cálculo intensivo y, como tales, deben ejecutarse dentro de un solo sitio y con interconexiones de baja latencia (Comisión Técnica de Grid UNAM, 2023).

HTC (High Throughput Computing).Modelo que permite a los usuarios la ejecución simultánea de un gran número de cálculos seriales o de memoria compartida; es decir, cálculos independientes o poco acoplados que utilizan desde uno hasta todos los núcleos de procesamiento de un solo nodo de cómputo, como puede ser el caso de los trabajos paramétricos (Comisión Técnica de Grid UNAM, 2023).

HTCondor. Es un software libre desarrollado por la Universidad de Wisconsin-Madison, con el objetivo de compartir recursos computacionales en un ambiente distribuido (Thain et al., 2004).

INDIGO. Es un software que administra el registro, autenticación, membresías y atributos de autorización en ambientes federados de autenticación (INDIGO IAM, s.f.).

Middleware. Capa que permite que ciertas aplicaciones y componentes de software interactúen en una grid, teniendo en cuenta la seguridad, la gestión de datos, el envío de tareas y la recuperación de resultados de forma transparente desde el punto de vista de los usuarios (Comisión Técnica de Grid UNAM, 2023).

MinIO. Sistema de almacenamiento basado en S3, escalable y compatible con necesidades de almacenamiento masivo requeridas en grid (Lackschewitz et al., 2022).

OpenID. Es una forma fácil y segura para que las personas reutilicen una cuenta y un perfil de usuario existente de un proveedor de identidad como Apple, Google o Microsoft, para iniciar sesión en cualquier aplicación o sitio web que tenga habilitado OpenID, sin necesidad de crear un nuevo registro o contraseña. El usuario elige el proveedor, como Google, e ingresa su dirección de Gmail y contraseña para iniciar sesión (OpenID foundation, 2023). Para la implementación del proyecto Grid UNAM, se utilizó el proveedor de identidades creado para la Red Inalámbrica Universitaria (RIU) de la UNAM.

S3. Acrónimo usado para referirse al producto de AWS Simple Storage Service, que, al ofrecer una gran variedad de funciones, ha logrado convertirse en la API más usada para los servicios de almacenamiento en la nube (Durner et al., 2023).

SLURM (Simple Linux Utility for Resource Management). Es un sistema de administración de recursos y de tareas (también llamado sistema de colas), empleado en clusters HPC para gestionar el acceso a recursos de cómputo y organizar la carga de trabajo con la finalidad de optimizar el uso y el aprovechamiento de los recursos disponibles (SchedMd, s.f.).

Token. Llave temporal que otorga un proveedor de identidad una vez que se haya realizado la autenticación del usuario para el acceso a los recursos y servicios (Comisión Técnica de Grid UNAM, 2023).